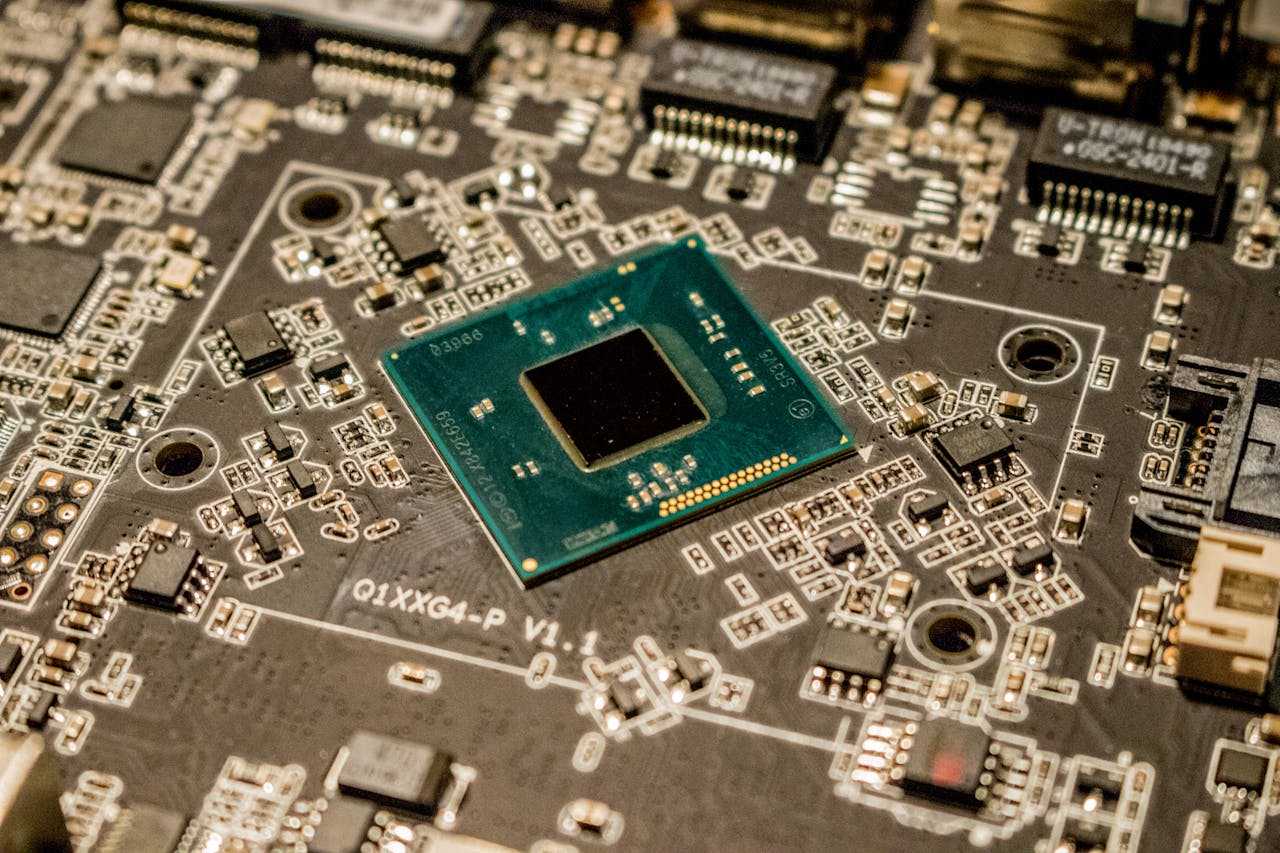

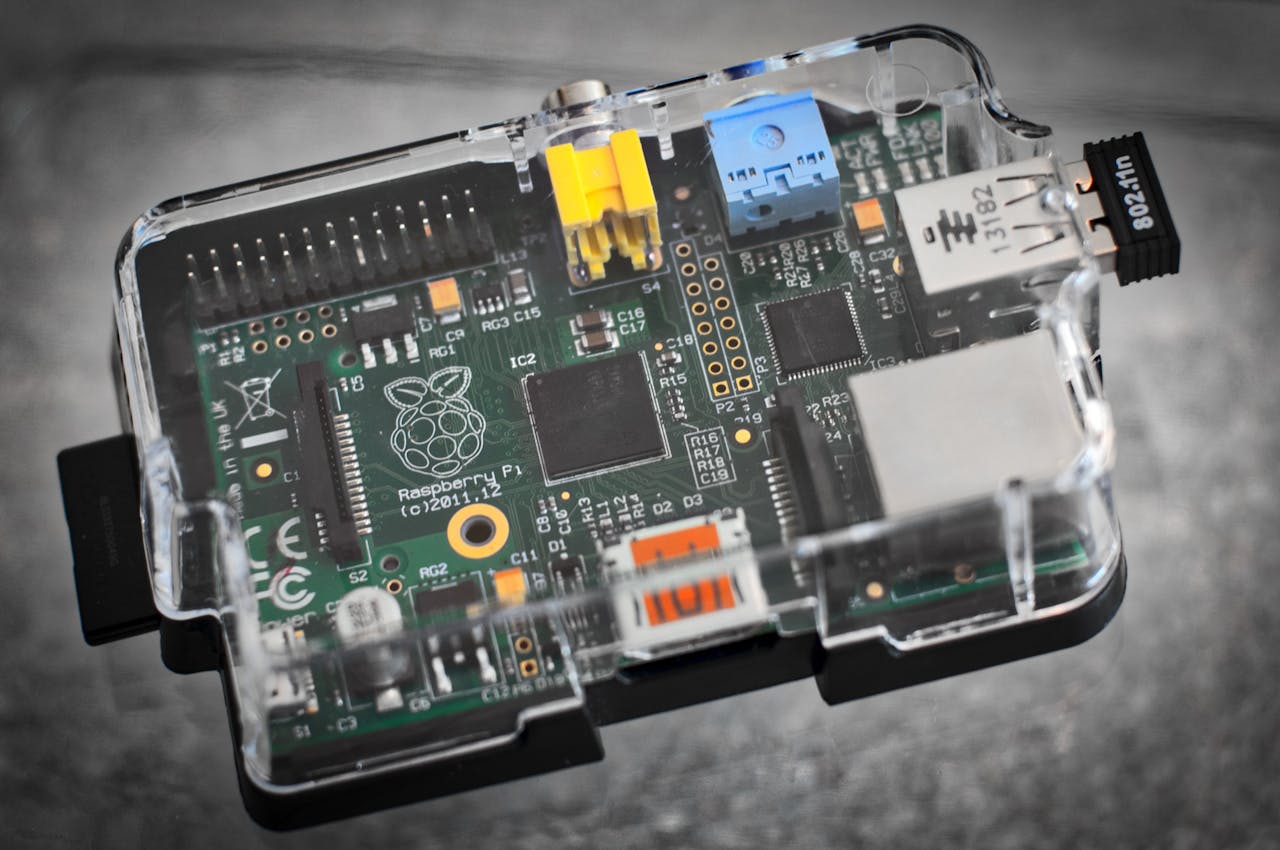

Kiedy myślisz „AI”, widzisz pewnie ogromne modele, GPU za tysiące dolarów i chmurę puchnącą od danych. Ale to już nie jedyna droga. Wchodzi nowy zawodnik: TinyML – czyli machine learning, który działa lokalnie na mikrokontrolerach, np. ARM Cortex-M, ESP32, STM32.

Bez internetu. Bez clouda. Bez lagów.

O co chodzi z TinyML?

To idea, żeby modele AI – np. do rozpoznawania dźwięku, gestów, obrazu, anomalii – uruchamiać bezpośrednio na chipie. Działa to na zasadzie bardzo lekkich, przetrenowanych modeli (często skompresowanych i zoptymalizowanych do poziomu kilkudziesięciu kilobajtów), które potrafią robić:

- Rozpoznawanie słów (np. „hej ESP” albo „wyłącz światło”)

- Wykrywanie gestów (np. z IMU, akcelerometru)

- Detekcję anomalii (np. nietypowa wibracja silnika)

- Klasyfikację obrazów (np. czy to kot, czy pies – na kamerze VGA!)

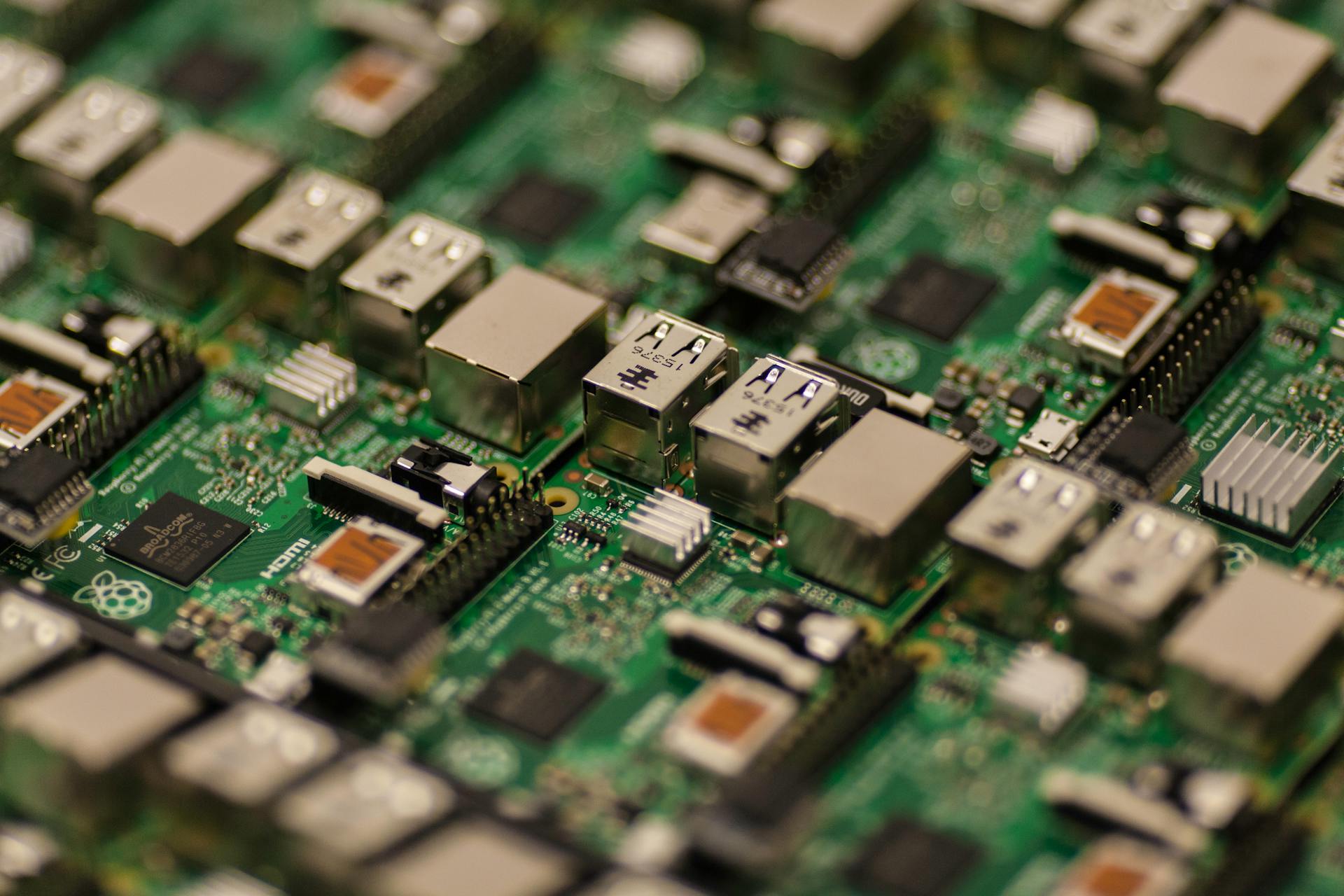

Frameworki takie jak TensorFlow Lite for Microcontrollers, Edge Impulse, albo CMSIS-NN robią robotę, a kod można odpalić na sprzęcie za mniej niż 10 zł.

Po co to komu?

- Prywatność – wszystko dzieje się lokalnie, nie trzeba wysyłać danych do chmury

- Energooszczędność – idealne do urządzeń na baterię (np. IoT, wearables)

- Reaktywność – brak opóźnień, brak internetu, wszystko działa od razu

- Skalowalność – jeden chip, jedno zadanie, zero kosztów utrzymania

To nie zabawka – są już komercyjne produkty, które działają tylko na TinyML. Kamery, sensory przemysłowe, smart-opaski, nawet wykrywacze awarii w silnikach przemysłowych.

Czy to trudne?

Trochę. Trzeba ogarnąć podstawy ML, konwersję modelu (np. z Keras do TFLite), optymalizację i flashowanie na chip. Ale narzędzia są coraz prostsze, a dokumentacja naprawdę solidna. A jak raz to ogarniesz – możliwości są ogromne.

Podsumowując:

TinyML to realna alternatywa dla AI w chmurze. I nie trzeba do tego Tesli z GPU – wystarczy ESP32, trochę RAM-u i dobry pomysł. Jeśli jarasz się elektroniką i AI, to właśnie tutaj zaczyna się przyszłość, którą można realnie wlutować.